Date

- 06.12.19

- BLOG

Algorithme – source : ttps://commons.wikimedia.org

Ils sont partout et transforment nos vies et notre monde en profondeur. Assistant de plus en plus les humains dans leurs métiers, ils peuvent aussi contribuer à les priver de leur liberté. Les algorithmes font l’objet d’autant de fascinations que de craintes. Serge Abiteboul et Gilles Dowek entreprennent de dresser le portrait de ce Temps des algorithmes (Le Pommier, 2017), afin d’en mettre en lumière la véritable nature. Les algorithmes seront ce que nous en ferons. Une lecture passionnante qui intéressera tout un chacun.

« Bienvenue dans la Matrice, Néo ! » : près de vingt ans après sa sortie dans les salles, le film de science-fiction devenu culte reste d’actualité. #Intelligence Artificielle et #Algorithmes sont de nos jours sur presque toutes les lèvres, les plumes ou les claviers… Avec un autre film, typique d’une époque, celle de la contestation de pouvoirs, fondée sur une défiance et une méfiance à leur égard – et d’un salutaire contre-pouvoir porté par la presse –, Sydney Pollack, anticipait de quelques décennies l’importance des données et de leurs liens. Dans Les trois jours du condor (1975), Robert Redford incarne Joseph Turner, employé dans une officine de la CIA à New York. Son métier ? Lire une quantité d’informations trouvées dans des supports différents (livres, journaux, rapports, etc.) afin d’y découvrir des relations inattendues – les intentions stratégiques d’États, d’organisations, d’entreprises, etc. Sans le savoir, il en met une au jour, ce qui le précipite dans une course pour la vie. Il se sort de situations délicates grâce à une imagination qui prend de court ses poursuivants. L’un d’eux se demande comment il fait. « Il lit beaucoup » répond un autre…

La lecture, une technique de Big-Data… 100% humaine ? Celle du Temps des algorithmes passionnera en tout cas tous ceux que ces questions intéressent et interrogent. Serge Abiteboul et Gilles Dowek, chercheurs à l’INRIA (Institut National de Recherche en Informatique et Automatique), vivent au quotidien avec les algorithmes… Ils en parlent avec lucidité, rappelant les opportunités qu’ils proposent, comme les risques qu’ils peuvent induire.

Précieux alliés des humains

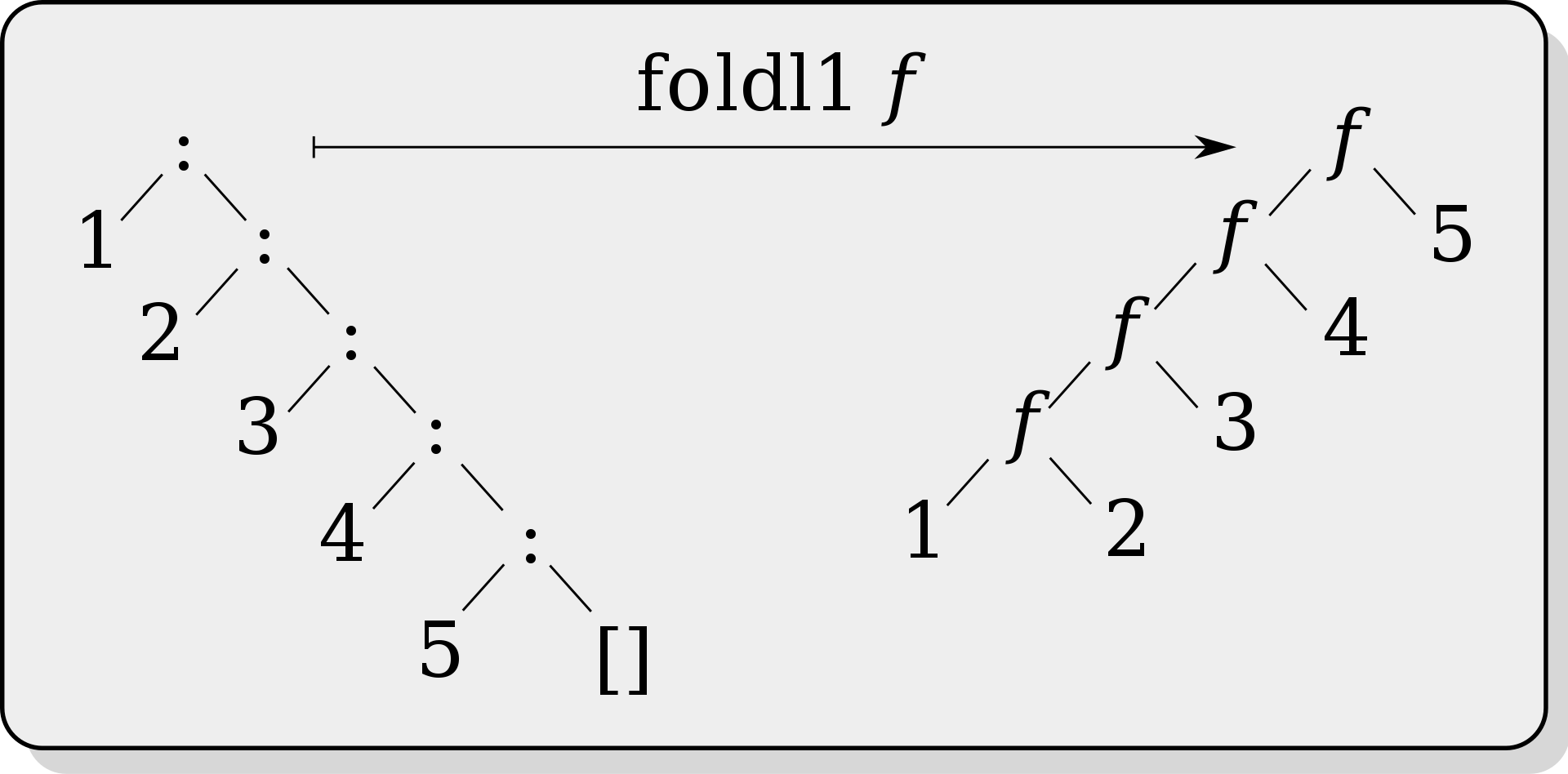

Un algorithme est une procédure décrivant, à l’aide d’un enchaînement déterminé d’opérations élémentaires (arithmétiques ou logiques), une démarche systématique permettant la résolution d’un problème ou la réalisation d’une tâche en un nombre donné d’étapes. Algorithme provient du mot arabe al-jabr, qui a son nom à l’algèbre, une branche des mathématiques dont les concepts sont la base de nombreuses techniques numériques. Il figure dans l’un des premiers traités de la discipline, attribué au mathématicien ouzbek Al-Khwârizmî (790-850). L’algèbre est le fruit d’une construction intellectuelle entamée il y a plus de quatre mille ans par les civilisations babyloniennes et égyptiennes et à laquelle ont contribué les civilisations indiennes, chinoises, arabes et européennes. Chacune d’elle y a apposé son empreinte, théorique ou algorithmique : un simple objet comme le boulier asiatique en est une. La machine arithmétique de Blaise Pascal conçue au XVIIème siècle pour le calcul comptable ou la machine d’Alan Turing, imaginée à l’aube de la Seconde Guerre mondiale afin de décoder la machine « Enigma » cryptant les messages des armées du IIIème Reich, opèrent des algorithmes de calcul plus ou moins complexes…

Nous utilisons des algorithmes dans notre quotidien, rappellent Gilles Dowek et Serge Abiteboul : en réalisant une recette de cuisine, en suivant un itinéraire proposé par notre système de guidage, en effectuant un achat sur Internet. Nous sommes aussi à certains égards des algorithmes vivants, explique Yuval Noah Hariri (Homo-Deus, Albin Michel, 2017), gouvernés par nos pensées, émotions et sensations :

99% des décisions que nous prenons, y compris les choix les plus importants concernant notre conjoint, notre carrière et notre habitation sont le fruit d’algorithmes raffinés que nous appelons sensations, émotions et désirs.

Les algorithmes prennent aujourd’hui une importance considérable en particulier par leur capacité à réaliser des calculs complexes, à stocker et transmettre de l’information, et à apprendre à partir de données.

Les ingénieurs les utilisent de longue datent pour le calcul scientifique (Michel Bernadou. Le calcul scientifique. « Que sais-je ? », Presses Universitaires de France, 2001). A l’aide d’équations, la simulation numérique décrit les phénomènes physiques en jeu dans de nombreux domaines (transport, énergie, climat, météorologie, etc.). Simuler, c’est exploiter la modélisation mathématique du monde réel telle que contenue dans les équations rendant compte de phénomènes physiques, et la coupler avec la puissance de calcul offerte par les ordinateurs modernes. Afin de comprendre, concevoir, prévoir et optimiser. Les ingénieurs travaillent avec des algorithmes au quotidien : ces derniers se cachent derrière la quasi-totalité des produits et des services que nous consommons – et consommerons demain.

Avec l’émergence des techniques de Big-Data (Pierre Delort. Le Big-Data. « Que sais-je ? », Presses Universitaires de France, 2015.), les services que nous rendent les algorithmes en apprenant des données sont potentiellement nombreux :

• Proposer des offres de service ciblées à des entreprises et des particuliers, anticiper des difficultés de circulation sur un réseau routier ou optimiser la disponibilité d’énergie ;

• Assister un chirurgien ou un médecin en vue d’un diagnostic ou d’un traitement ; un juriste dans l’exercice du droit ou un agent d’assurance dans la gestion des risques ; un responsable de ressources humaines dans un recrutement, un journaliste dans ses investigations ou la présentation de résultats systématiques ; un ingénieur dans la maintenance prédictive d’installations (surveillance du vieillissement d’un pont, du fonctionnement d’une machine, etc.).

Leur capacité à apprendre fait aussi des algorithmes de véritables mouchards et leur utilisation afin de connaître nos vies peut parfois de façon insidieuse entraîner des dérives dont nous prenons collectivement conscience.

Omniscience, omnipotence et surveillance

Location de bien ou échanges de service entre individus, plateforme d’assistance ou de vente à distance : les outils numériques généralisent dans nos pratiques quotidiennes la notation de tous par chacun. Cette tendance est exclusivement présentée selon ses opportunités : il s’agit à chaque fois d’améliorer un service, ou de prémunir leurs utilisateurs contre de potentiels usages frauduleux. Nous nourrissons aussi de la sorte des algorithmes qui pourront contribuer à prendre des décisions visant à exclure insidieusement les plus faibles, les plus fragiles, les moins performants ou les moins normés d’entre nous – les plus mal notés par les algorithmes, au nom de quelles valeurs ? Nous habituons-nous à ce système de notation intra-personnel, partie émergée d’un iceberg plus inquiétant lorsqu’il est organisé par des gouvernements ou des grandes entreprises à des fins politiques et commerciales. Système de surveillance conçu pour prémunir la société tout entière de pratiques qui sapent sa cohésion (comme la corruption), etc. ou pour contrôler l’ensemble de ses citoyens et consommateurs ? (John Harris, « The tyranny of algorithms is part of our lives: soon they could rate everything we do », The Guardian, 5 mars 2018).

Le sociologue français Dominique Cardon résume la façon dont les algorithmes utilisent les données afin de nous connaître :

« Les algorithmes utilisent les traces de notre passé pour connaître notre futur… »

Parmi ces traces, celles laissées par notre activité numérique (Mélanie Dulong de Rosnay, « Les traces de l’activité humaine dans le numérique » ; Matthieu Lapaty, David Chavalrias, « L’analyse à grande échelle de nos traces numériques ». Les Big-Data à découvert, CNRS Editions, 2017). Vidéos consultées sur YouTube, interrogations de Google, achats sur Amazon, likes sur FaceBook pour ne citer que les plus évidentes ! En rapprochant l’achat d’un livre sur un sujet donné avec une consultation d’un site Internet sur un autre sujet, puis d’une réaction à un post sur un autre sujet, etc., on peut espérer connaître un profil-type d’un internaute (opinions politiques, adhésions religieuses, comportement d’achat, préférences amoureuses… ou autres, avec des modèles de plus en plus fins !) et proposer entre autres des offres commerciales personnalisées.

À partir de ces données, parfois sans rapport apparent ou direct, des analystes construisent des modèles de comportement à l’aide de techniques d’apprentissage algorithmique (Wu Youyou, Michal Kosinski, DAVID Stillwell. Computer-based personnality are more accurate than those made by humans. Proceedings of the National Academy of Science, 112, 1036-1040, 2015).

Les développements récents de l’apprentissage algorithmique et du traitement statistique des données montre que des modèles numériques deviennent capables de réaliser des évaluations de personnalités en utilisant les traces digitales des comportements humains.

Ainsi cet outil d’analyse de personnalité proposé par IBM : Personnality Insight propose de dresser les grandes lignes de notre portrait psychologique sur la base d’un texte écrit. En croisant les mots utilisés et en les analysant à l’aune d’un modèle psychologique très utilisé en sciences sociales – le fameux OCEAN ([Martine Bouvrad « Les cinq dimensions de la personnalité », Cerveau & Psycho, Septembre-Octobre 2015).

Disposer de modèles numériques prédictifs de traits de personnalité et de comportements pourrait changer de nombreuses pratiques humaines. C’est déjà le cas dans certains domaines comme les ressources humaines (analyse de personnalité d’un candidat lors d’un recrutement), la vente et le commerce (analyse des habitudes de consommation d’un client potentiel). Selon leurs concepteurs, ces modèles deviennent à ce point fiable que la capacité de jugement des algorithmes dépassera celle des humains afin de décrire (et à prédire) une partie de nos choix de vie – amoureux, commerciaux… comme électoraux !

Notre inconscient est à portée d’algorithme… comme notre inconscient collectif qui reste à explorer.

Seth Stephens-Davidowitz, un expert américain en traitement de données, affirme ainsi qu’il est de nos jours impossible de mentir aux algorithmes du Big-Data – alors que nous mentons selon lui sans difficulté aux humains (« Everybody lies: how Google search reveals our darkest secrets », The Guardian, 9 juillet 2017) :

« Tout le monde ment (…) Nous mentons à nos amis. Nous mentons à nos patrons. Nous mentons à nos enfants. Nous mentons à nos parents. (…) Et nous mentons plus encore aux enquêtes (d’opinion, de sociologie, etc.). (…) Comment, dans ces conditions, pouvons-nous savoir ce que nous pensons et faisons vraiment ? Avec le Big-Data. Certaines pratiques en ligne (comme les recherches sur Internet) nous poussent à notre insu à révéler des comportements et des préférences que nous cachons aux autres. Elles agissent comme de véritables ‘sérum de vérité numérique’… »

Google traite plus de 3 milliards de requêtes par jour. Posons lui une question, il propose spontanément des suggestions fondées sur les recherches les plus nombreuses formulées par d’autres. Ses réponses sont aussi le reflet de nos propres requêtes antérieures – collectives comme individuelles. L’information présentée en réponse à une requête n’est pas anodine : l’algorithme choisit pour nous la hiérarchie des données mises à notre disposition en fonction de ce qu’il connaît déjà de nous. Nous sommes enfermés par ce biais dans une « bulle cognitive ». Nous nous trouvons ainsi moins souvent confrontés à des modes de pensée différents des nôtres par le biais de nos recherches sur Internet… ce qui n’est pas sans poser de sérieuses questions quant à notre liberté, notre curiosité – et à la diversité des points de vue utiles à l’exercice de choix politiques, comme le souligne le juriste américain Lawrence Lessig (« «On doit s’inquiéter de la manière dont Internet nourrit la polarisation» » – propos rapportés par Amaelle Guitonn, Libération, 16 décembre 2016) :

« Nous sommes passés de plateformes communes à des plateformes de plus en plus fragmentées, qui produisent un monde dans lequel chacun vit dans sa propre bulle d’information. (…) Nous ne savons pas comment construire un espace dans lequel les gens pourraient discuter des mêmes questions politiques, à partir d’un cadre commun et d’une compréhension partagée des faits (…) – à cause des algorithmes et de l’architecture du réseau.»

La chercheure américaine Sofiya Noble s’intéresse aux techniques de communication numériques et à l’influence qu’elles ont sur l’organisation de nos sociétés (Algorithm of Opression. NYU Press, 2018). Elle met en évidence l’importance des biais sociaux et ethniques dans la conception de plateformes Internet. La majorité des algorithmes sont aujourd’hui développés par des hommes, et peu de femmes – des hommes blancs, cadres supérieurs de pays industrialisés (Etats-Unis, Japon, Corée, Chine et Europe). Une partie de leurs préférences et de leurs critères de choix est reproduit par les algorithmes. Le monde d’une minorité s’imposerait par ce biais à l’ensemble des utilisateurs. Dans un contexte commercial, l’utilisation des données n’est ni neutre ni objective : elle engendre potentiellement, selon la chercheure, des comportements et modes de pensée racistes ou sexistes. Notons aussi que les algorithmes permettent aussi de mettre à jours certains de ces préjugés ! (Annabelle Laurent, « Un algorithme révèle l’évolution des stéréotypes de genre et raciaux depuis 1900 », Usbek & Rika, 9 avril 2018)

Le romancier Marc Dugain et le journaliste Christophe Labbe examinent les conséquences de ces choix sur l’organisation de nos sociétés (L’homme nu, Seuil, 2016). Selon eux, certaines techniques numériques contribuent à une modélisation des comportements humains avec une précision jamais égalée à ce jour. Ils en expliquent les risques potentiels s’agissant de la modification des relations politiques et économiques mondiales, et du rapport des êtres humains entre eux, au monde… et à leur avenir ! Leur propos est plutôt pessimiste : selon eux, ces techniques ont quasiment aboli les marges de liberté des humains. Leur concentration par un petit nombre d’entreprises américaines, les GAFAM et leurs alter-ego chinoises, les BATX, obère selon eux les marges de manœuvre et de décision qui restaient encore propres aux organisations humaines.

Internet est devenu accessible à une fraction significative de l’humanité au début du XXIème siècle. Les premières architectures de la Toile ont été développées afin de répondre au besoin de deux communautés humaines, militaires et universitaires, pour qui le partage et la transmission d’informations et de données est un enjeu stratégique. Internet est devenu un formidable outil d’information et de communication – avec leur face sombre : une potentielle perte de libertés individuelles et collectives, confisquées par le pouvoir économique ou politique exorbitant des entreprises ou Etats qui le contrôlent. Les données et les connexions que permet ce réseau mondial donnent corps au cerveau numérique des intelligences artificielles. Dans les années 1950, alors que les esprits les plus brillants imaginaient l’importance qu’allaient prendre l’automatique et l’informatique, qui avait imaginé que l’IA se développe au moyen de cette technique ?

Imitation game

L’IA se caractérise également par sa capacité à apprendre des humains – de façon supervisée (au moyen de données que les algorithmes analysent) ou non (les algorithmes sont conçus afin de réaliser seuls l’apprentissage). Le projet de l’IA est porteur d’autant d’opportunités que de risques. À ce jour, il dépend des humains et il est leur reflet.

Les humains proposent des modèles, programment les codes de calcul et les algorithmes – et décident au moment de leur conception de certains critères de choix de ces derniers. Quelles représentations du monde les humains apprennent-ils aux machines ? Elles ne sont pas uniquement physiques ou mathématiques, elles sont aussi éthiques ou philosophiques. Le développement des voitures automatiques, des robots chirurgiens ou des armes autonomes est au cœur de ces questions (Alexandre Lacroix, « Les machines vont-elles nous faire la morale ? », Philosophie Magazine, 118, 57-61, 2018).

Ces représentations du monde proviennent des humains qui les conçoivent. Ainsi, certaines préférences des programmeurs sont inculquées aux algorithmes. Un programme d’apprentissage n’est pas doté de conscience ou de valeurs. Faisons-lui apprendre un processus à partir de données issues par exemple de discours ou d’écrits que la décence commune trouve discriminants, violents ou injurieux, l’intelligence artificielle les reproduira dans son dialogue numérique avec les humains. Des données issues d’une représentation du monde des programmeurs (celui d’hommes, majoritairement blancs, vivant dans le monde occidental, et ne concernant qu’une faible fraction de l’humanité), nous verrons celle-ci à l’œuvre dans les restitutions des algorithmes. Au risque de ne pas faire de place à la différence et à la diversité.

Cela pose des problèmes éthiques et politiques si l’on confie à un algorithme le soin de prendre des décisions ayant des conséquences sur nos vies (rendre un jugement, établir un diagnostic, procéder à un recrutement, attribuer un emprunt, une bourse ou une place à l’université, mettre en relation avec quelqu’un etc.) sans que nous ayons la possibilité de comprendre les raisons de cette décision… ou de ne pas nous laisser les moyens collectifs ou individuels de garder le pouvoir de décision finale.

Il est indispensable de pouvoir avoir recours à une personne responsable qui doit pouvoir opposer sa décision à celle de l’algorithme…

« Ce qu’un humain est capable d’imaginer, des algorithmes seront capables un jour de l’accomplir », pourrions-nous écrire en paraphrasant Jules Verne. Reproduisant toujours plus efficacement les intelligences humaines, l’IA nous donne l’illusion de la perfection, laquelle ferait croire qu’un robot puisse se faire passer pour un humain, et qu’il faudrait craindre ces Répliquants de métal, selon Serge Tisseron (Petit traité de cyber-psychologie. Éditions Le Pommier, 2018) :

Ce ne sont pas les robots qu’il faut craindre – mais leurs fabricants, qui, pour en vendre le plus possible, risquent de nous proposer des machines qui nous fassent perdre le goût de l’humain.

En ouverture du film Matrix, un coup de génie cinématographique et mathématique : des chiffres s’écoulent comme une goutte d’eau sur une vitre par un jour de pluie, formant une colonne (un vecteur, pour employer un jargon algébrique). Ne subsiste alors qu’un chiffre : une valeur propre de la matrice ! De la masse de chiffres (ou de données), collectées dans cette matrice constituée des traces numériques laissées au gré de nos explorations, nos consultations et nos interrogations de la Toile, il est possible d’extraire des tendances et des corrélations alimentant des modèles de consommation économique et politique, construits à l’aide d’algorithmes super-efficaces, et capables d’extraire une information pertinente. Que nous le voulions ou non, nous nourrissons ces algorithmes, sur lesquels se fonde une forme d’intelligence nouvelle semblant acquérir en miroir nos qualités et défauts, et transformant notre rapport au monde. Dans le film, le « méchant » du monde numérique de la Matrice est un algorithme. Celui qui peut aussi nous priver de notre libre arbitre, lorsqu’il se met à décider de tout, en nous proposant un monde spécialement conçu pour nous…

Face au risque de voir les algorithmes utilisés afin de connaître nos comportements, et les influencer, nous conservons néanmoins par nos choix une réelle marge de manœuvre, sachant que ceux-ci, comme nos jugements, ont souvent une part plus irrationnelle que nous voulons bien l’admettre… qui échappe encore heureusement à toute réduction algorithmique ?

Serge Abiteboul, Gilles Dowek– Le Temps des algorithmes. Le Pommier, 2017 (190 pages, 17€).